用robots文件做好seo優化

編輯

編輯

分享

分享

評論

評論

贊0

贊0

robots文件存在于網站根目錄,是用來告訴百度蜘蛛那些應該抓取,那些不應該抓取。正確使用robots文件有助于做好seo優化,robots文件的核心詞匯就是allow和disallow用法。百度官網是認可這個文件的,在百度站長平臺上也有robots這個欄目,點擊進入,就可以看到你網站robots文件是否編寫正確了。

百度robots文件使用說明

1、robots.txt可以告訴百度您網站的哪些頁面可以被抓取,哪些頁面不可以被抓取。

2、您可以通過Robots工具來創建、校驗、更新您的robots.txt文件,或查看您網站robots.txt文件在百度生效的情況。

3、Robots工具暫不支持https站點。

4、Robots工具目前支持48k的文件內容檢測,請保證您的robots.txt文件不要過大,目錄最長不超過250個字符。

利用robots文件做seo優化,讓蜘蛛更好的抓取網站。

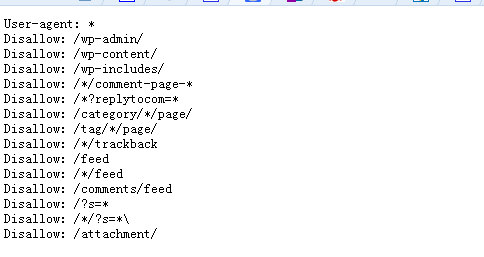

上圖disallow語句有問題,原因是把英文的冒號寫成了中文的冒號。

當然直接輸入網站根目錄加上robtots.txt文件也可以。

User-agent:* 是用來置頂那些搜索引擎蜘蛛可以抓取的,一般默認設置

Disallow:/category/*/page/ 分類目錄下面翻頁后的鏈接,比如,進入校賺網分類目錄 "推廣運營經驗"目錄后,在翻頁一次,就成了 stcash.com/category/tuiguangyunying/page/2形式了

Disallow:/?s=* Disallow:/*/?s=* 搜索結果頁面和分類目錄搜索結果頁面,這里沒必要再次抓取。

Disallow:/wp-admin/ Disallow:/wp-content/ Disallow:/wp-includes/ 這三個目錄是系統目錄,一般都是屏蔽蜘蛛抓取

Disallow:/*/trackback trackback的鏈接

Disallow:/feed Disallow:/*/feed Disallow:/comments/feed 訂閱鏈接

Disallow:/?p=* 文章短鏈接,會自動301跳轉到長連接

利用robots文件做seo優化,讓蜘蛛更好的抓取網站

Disallow:/*/comment-page-* 和Disallow:/*?replytocom* 來自于評論鏈接,很容易造成重復收錄。

在robots.txt文件的最后還可以制定sitemap文件 Sitemap:http://***.com/sitemap.txt

sitemap地址指令,主流是txt和xml格式。

在這里分享一段xt格式的simemap文件。將上述代碼保存到txt文件,上傳到根目錄,并且在robots.txt文件中指定即可。

User-agent: *

Disallow:/wp-admin/

Disallow: /*/comment-page-*

Disallow: /*?replytocom*

Disallow: /wp-content/

Disallow: /wp-includes/

Disallow: /category/*/page/

Disallow: /*/trackback

Disallow: /feed

Disallow: /*/feed

Disallow: /comments/feed

Disallow: /?s=*

Disallow: /*/?s=*\

Disallow: /attachment/

Disallow: /tag/*/page/

Sitemap: http://www.stcash.com/sitemap.xml

猜你喜歡

猜你喜歡